Мероприятие специального проекта команды OCS Soft — «ПРОдемо: Лаборатория программных решений». В нем участвует Александр Калинин, пресейл по резервному копированию в компании OCS и Александр Савостьянов, технический эксперт OCS, он сделает обзор архитектуры, расскажет про сценарии использования продукта, а также продемонстрирует основные элементы интерфейса управления, работу программно-определяемого хранилища данных и подсистемы виртуализации.

Сегодня они будут говорить про киберинфраструктуру. Недавно у нас обновился корпоративный дизайн? Кроме того, мы обновили наш демо-сайт. Здесь можно посмотреть демостенды, которые у нас есть по разным направлениям. Все они реализованы на базе нашего ЦОДа.

Три площадки, 65 серверов, 14 Тбайт оперативной памяти и неплохие сети, рабочие нормальные СХД, есть у нас графические карты. И к этим стендам мы даем удаленный доступ через технологию VDI.

Для наших партнеров мы оказываем ряд активностей таких, как анализ технических требований, демонстрация решений, подбор решений, пилоты и внедрение. Мы проводим различные семинары, обучающие курсы, вебинары. Здесь стенды для самостоятельного изучения. Иногда готовим индивидуальные стенды под требования заказчика и выдаем демо-оборудование.

Два больших раздела - это виртуализация и информационная безопасность. И здесь большое количество различных платформ. Главное, что на этом стенде можно нажать кнопочку "Подробнее", посмотреть какие-то скриншоты из консоли управления, посмотреть какие есть сценарии демонстрации, из чего состоит стенд, а также можно нажать кнопку "Забронировать". К нам в Telegram придет ваше пожелание, и мы обязательно с вами свяжемся и уточним, что конкретно хотите тестировать, какие вас устраивают сроки и т.д.

Затем слово взял Александр Савостьянов. Он сначала провел небольшую презентацию о продукте.

Киберинфраструктура это инфраструктура, в которой вычислительные ресурсы серверов и устройства хранения объединены на программном уровне. При таком способе представления в качестве аппаратной платформы используются только сервера стандартной архитектуры, что позволяет создать инфраструктуру любого масштаба для решения большего количества IT-задач.

В основе киберинфраструктуры лежит очень простая идея. Берутся серверы, они могут быть от разных производителей и разной конфигурации. Объединяются эти серверы сетевыми интерфейсами, подключаются во внешнюю и во внутреннюю сеть. Внутренняя сеть используется для взаимодействия между узлами и для кластерного интерконнекта, и используется для хранения данных. На "голое железо" устанавливается программное обеспечение, которое объединяет эти сервера в надежный производительный отказоустойчивый кластер. Все ресурсы у этих серверов - вычислительная мощность, память и хранилище объединяются в единый пул. Основана киберинфраструктура на операционной системе Linux. В дистрибутив входит операционная система, хотя есть опции, когда можно поставить операционную систему отдельно, а саму программу обеспечения киберинфраструктуры, уже поставить поверх операционной системы. Однако чаще всего все это ставится одновременно. Единый кластер объединенных серверов легко масштабируется путем добавления узлов и отдельных дисков.

На слайде мы видим, что в киберинфраструктуру входит программно-определяемые хранилища различных типов, программно-определяемая сеть и программно-определяемые вычисления. Все это управляется из веб-интерфейса, из командной строки, и есть системы управления и мониторинга.

Основным компонентом и тем, с чего достаточно давно начался этот продукт, является программно-определяемое хранилище.

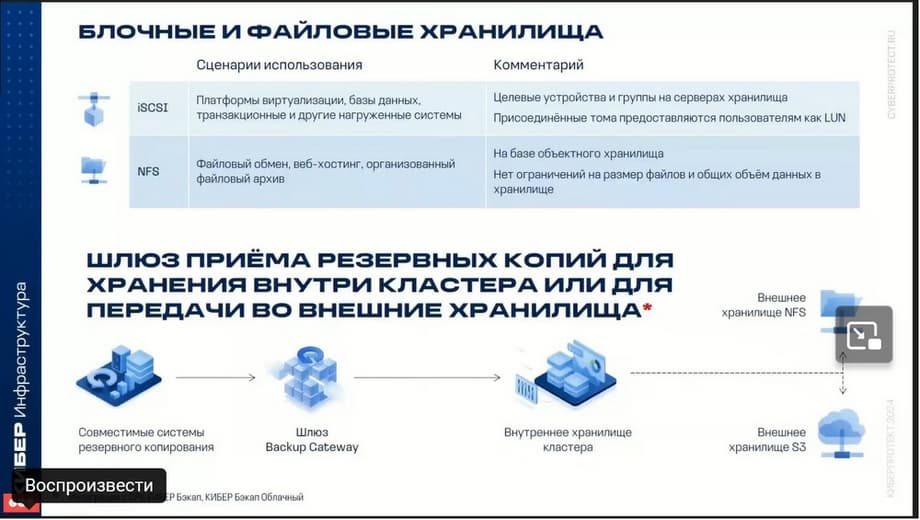

Киберинфраструктура позволяет создать различные типы хранилищ с доступом по протоколам NFS, iSCSI и S3. Также дополнительно для интеграции с другими продуктами Киберпротекта, продуктами резервного копирования, таких, как КИБЕР Бэкап Облачный и Кибер Бэкап еще используется специальное хранилище, которое обозначается аббревиатурой BGW (Backup Gateway). Таким образом поддерживаются различные типы хранилищ. Хранилище S3 для хранения неограниченного количества объектов и файлов, хотя там есть определенные ограничения, хотя они немного маркетинговые. Также блочные хранилища iSCSI используются и рекомендуются для виртуализации баз данных и других нагрузок. Как уже было сказано, также может быть использовано дополнительное хранилище в качестве шлюза Backup Gateway, которое предназначено для системы резервной копирования. Создание файловых, блочных и объектных систем хранения достигается путем объединения устройств хранения в единый пул. Т.е. дисковые ресурсы каждого из серверов добавляются в этот единый пул и, таким образом они объединяются в единое хранилище.

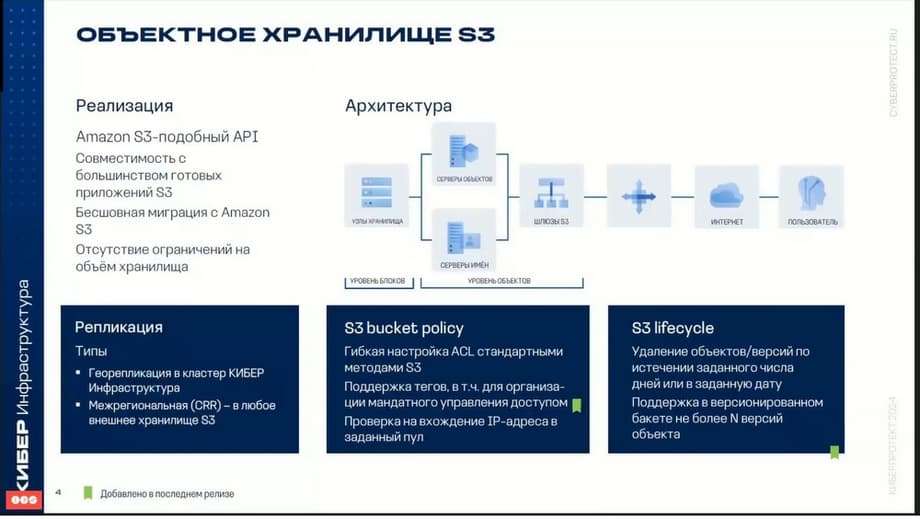

Одним из наиболее популярных сейчас типов хранилищ является объектное хранилище. Киберинфраструктура позволяет экспортировать дисковое пространство кластера в форме S3 совместимых хранилищ.

Объектные хранилища оптимизированы для хранения миллиардов объектов, данных и приложений, можно там хранить объекты различного статического веб-контента, данные сервисов онлайн-хранилища, больших данных, резервных копий и т.д. Ключевое отличие по сравнению с другими типами хранилищ, которые используются в киберинфраструктуре, состоит в том, что части объекта нельзя изменить. Т.е. при изменении объекта формируется его новая версия. Киберинфраструктура может хранить реплики данных кластера S3 и поддерживать их в актуальном состоянии в нескольких географически распределённых центрах обработки данных. Т.е. имеется возможность георепликации из одного хранилища в другое. Таким образом их можно использовать для катастрофоустойчивости данных.

Блочные и файловые хранилища. В первую очередь имеет смысл говорить про iSCSI и NFS. Это основные дополнительные системы типа хранилищ. iSCSI рекомендуется использовать для виртуализации баз данных и других нагрузок. Например, баз данных и транзакционных систем. Обмен данными с хранилищем происходит быстро за счет обеспечения высокой скорости чтения и записи. Для увеличения скорости можно использовать дополнительные средства, такие как RDMA, который работает поверх InfiniBand, но это именно для обеспечения высокой производительности хранения.

Файловые хранилища NFS можно использовать для хранения любых типов корпоративных данных с доступом по NFS. Само хранилище NFS построено на базе объектного хранилища, и может масштабироваться до миллиардов сущностей. Обладает высокой производительностью, но для использования хранилища, где требуется высокая производительность ввода-вывода, рекомендуется использовать iSCSI, а не NFS.

Еще один тип хранилища – это шлюз резервного копирования. Системы резервного копирования Кибер Бэкап и Кибер Бэкап Облачный в рамках задач резервного копирования и репликации передают резервные копии в шлюз. Таким образом саму киберинфраструктуру можно использовать в качестве хранилищ резервных копий, а можно использовать в качестве шлюза для того, чтобы иметь возможность использовать шлюз для хранения внутри самого хранилища резервной копии, а можно использовать шлюз в качестве некого кэша, который будет использоваться для передачи данных дальше во внешней системе хранения. Это может быть либо S3, либо NFS. Как это работает? Шлюз используется в качестве кэша. Данные сначала поступают на шлюз, а затем они поступают уже дальше на внешнее хранилище S3 или NFS.

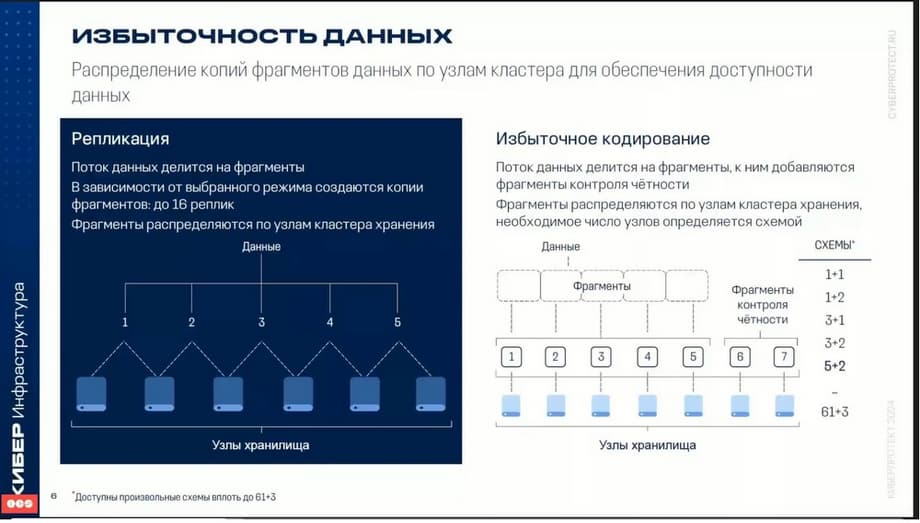

Для защиты данных используется избыточность при хранении. Используются две технологии. Одна технология называется репликация, другая — избыточная кодирование.

Репликация — это, по сути, зеркалирование данных. Репликация работает следующим образом: поток данных делится на отдельные блоки, каждый из которых сохраняется в два или три места на других серверах. Таким образом, происходит избыточность данных, либо 100%, либо 200% избыточности данных, но при этом достигается максимальная защита от сбоя. Избыточное кодирование или, по-английски, это RG-кодинг, это механизм деления потоков на отдельные блоки по определённой схеме избыточности. Используются различные схемы: 1+1, 1+2, 3+1, 3+2, 5+2,…, 61+3. Какую схему использовать, зависит от выбора различных критериев. Можно использовать с максимальной надёжностью выхода из строя двух и более узлов, а можно рассматривать более высокопроизводительные схемы.

Области отказа. Высокая доступность систем обеспечивается за счет гибких настроек, среди которых можно выделить области отказа.

В качестве зоны отказа может быть выбран диск, хост, сервер или даже целая стойка. В этом случае данные распределяются между отдельными компонентами того же уровня. Т.е. между дисками, между серверами, но чаще всего это происходит именно между серверами. Я буду показывать то, где данные распределяются между различными серверами. Таким образом, выход из строя одного или даже двух серверов не приводит к потере данных. При выходе из строя какого-то компонента, допустим, сервера, данные, которые были на этом сервере, перераспределяются на другие сервера. Т.е. если на сервере, который вышел из строя, находились какие-то копии данных, то эти копии данных будут распределены по другим серверам таким образом, чтобы соблюдался уровень отказоустойчивости. Т.е. если уровень отказоустойчивости, допустим, реплики, два или три, то данные будут перераспределены таким образом, чтобы обеспечить нужный уровень защиты данных. Ну и, естественно, это зависит еще и от того, есть ли при этом в кластере свободное пространство.

Киберинфраструктура позволяет распределить данные по нескольким уровням хранения и даже автоматически балансировать данные. Смысл состоит в том, что можно по разным уровням хранения распределить различные нагрузки.

Допустим, здесь на слайде видно, что транзакционные нагрузки или горячие данные можно распределить на уровень, где находятся NVMe-диски. Следующий уровень - это SSD-диски. На нём, например, можно расположить данные баз данных или данные объектного хранилища. На третьем уровне - самые медленные диски. На этом уровне можно хранить, например, резервные копии или какие-то холодные файлы.

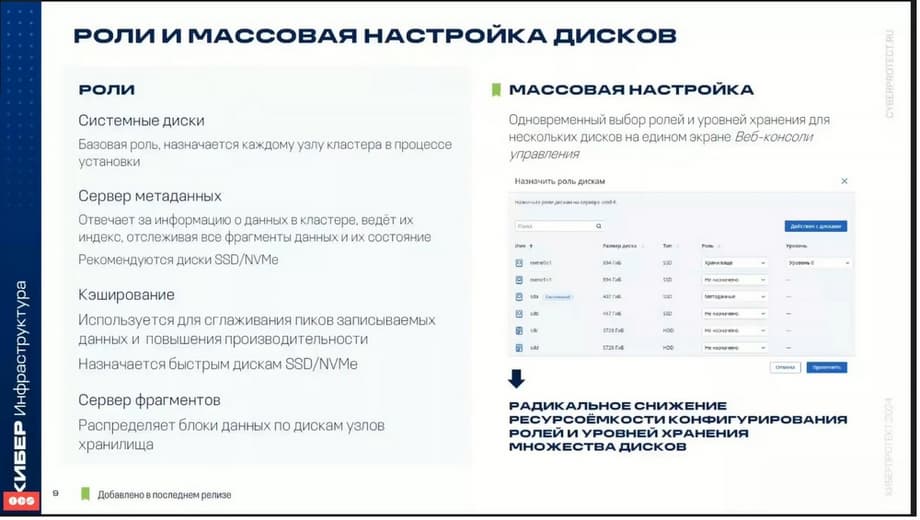

Если говорить о технических моментах при настройке, то вы столкнетесь с тем, что дискам, которые находятся на сервере, назначаются разные роли.

Первая роль системному диску нужна для того, чтобы установить операционную систему и программное обеспечение. Второй уровень - это сервер метаданных. Серверы метаданных отвечают за информацию данных о кластере, отслеживают фрагменты данных, состояние и т.д. Сервер метаданных обязательно должен быть не один. Рекомендуются два и более серверов. Третий уровень - кэширование. Некоторые диски можно назначить в качестве кэша. Например, если у нас в качестве основных дисков хранилища используются обычные HDD-диски, то в качестве кэша можно использовать SSD для того, чтобы увеличить производительность. Последний уровень – это сервер фрагментов, он выполняет роль хранилища.

Теперь переходим к программно-определяемым вычислениям. В состав киберинфраструктуры входит платформа виртуализации. То есть поверх хранилища можно развернуть платформу виртуализации. В качестве платформы виртуализации используется OpenStack. И те, кто знаком с возможностями OpenStack, сразу убедятся, что все возможности данного продукта присутствуют. Хранение виртуальных машин, которые создаются в качестве хранилища, используется либо само хранилище киберинфраструктуры, либо внешнее хранилище.

В качестве гостевых операционных систем, естественно, могут выступать различные операционные системы семейства Windows, а также семейства Linux. Продукт обладает всеми основными свойствами и функциями, которые должны быть у современной системы виртуализации. Поддерживается весь жизненный цикл виртуальных машин. Т.е. создание шаблонов, включение-выключение, перенос машин между узлами. В продукте реализованы все основные функции, плюс некоторые дополнительные возможности, которыми обладает не каждая система виртуализации. Например, можно задать правила хранения и политики хранения виртуальных машин. Если от виртуальной машины требуется высокая производительность, то ее можно расположить на определенном уровне хранения, который обладает более высокой производительностью ввода-вывода. А можно, и это можно задать в настройках виртуальной машины, сделать так, чтобы в дальнейшем, при миграции между узлами, данная виртуальная машина могла бы располагаться на другом уровне.

Система виртуализации обеспечивает высокую доступность виртуальных машин. То есть при выходе из строя узла сервера, на котором работала виртуальная машина, она может быть эвакуирована на другой узел. Для переноса виртуальных машин между узлами существуют режимы как холодной миграции, так и горячей миграции. В одной из последних версий была введена возможность ДРС – это возможность балансировки нагрузки по CPU и памяти. Данная возможность позволяет автоматически, без остановки, перемещать виртуальные машины между серверами виртуализации для повышения производительности. Это тоже настраивается. Администратор может, например, исключить отдельные машины из данного процесса или, наоборот, включить их.

Поддерживается механизм создания моментальных снимков. Надо сказать, что в последней версии еще была включена фишка с тем, чтобы поверх системы виртуализации, можно было развернуть виртуализацию рабочих столов, то есть VDI инфраструктуры рабочих столов. Вот это основные возможности.

Что касается размещения дисков виртуальных машин.

Самое простое и очевидное – это когда диски виртуальных машин хранятся в том же хранилище киберинфраструктуры. Но также можно использовать в ней диски внешних СХД. Это было добавлено в последней версии. На текущий момент поддерживаются две СХД. Это Huawei Dorado и HPE 3PAR. Работает это также, как в VMware. Аналог того, что в VMware называлось Vivo. То есть на СХД через API на СХД киберинфраструктура может создать необходимые диски и подцепить их к виртуальной машине на внешних СХД через API. Вот так это работает.

В ближайших версиях планируется поддерживать протокол Fibre Channel. Сейчас поддерживается только iSCSI, но эта технология будет развиваться. Многие заказчики об этом спрашивают. Поэтому будет следующая версия c поддержкой Fibre Channel протокола, чтобы можно было внешне из HD подцеплять через Fibre Channel интерфейс.

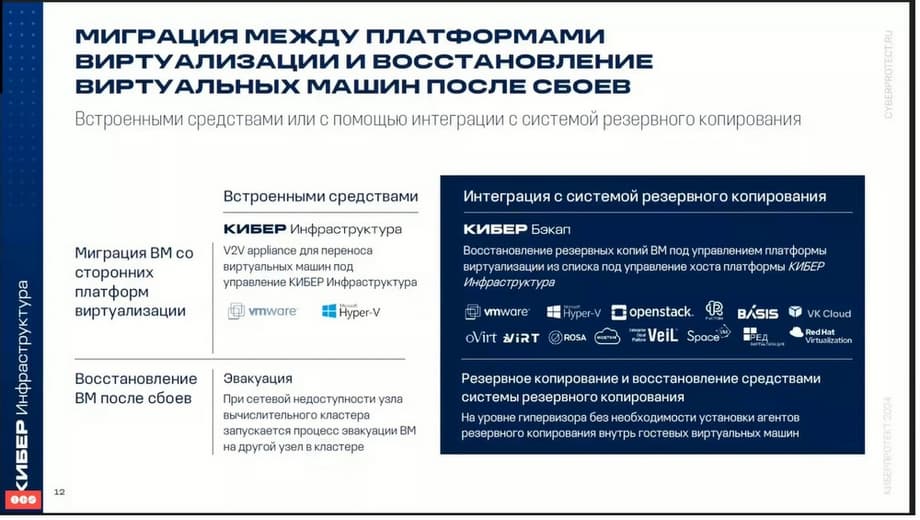

Миграция между платформами. Киберинфраструктура осуществляет миграцию виртуальных машин из VMware, Hyper-V внутрь киберинфраструктуры с помощью виртуального appliance. Виртуальный appliance называется V2V appliance для переноса виртуальных машин. Миграция виртуальных машин из VMware доступна в автономном режиме и онлайн режимах. Миграция виртуальных машин Hyper-V доступна только в автономном режиме.

Программно-определяемая сеть. Как уже было сказано, система виртуализации основана на продукте OpenStack. Поэтому многие вещи известны и понятны для тех, кто знаком с тем, как устроен OpenStack.

Киберинфраструктура поддерживает виртуальную коммутацию на базе OpenViSwitch. Коммутатор OpenViSwitch запускается на каждом вычислительном узле, перенаправляет сетевой трафик между виртуальными машинами на этом узле, а также между виртуальными машинами и сетями инфраструктуры, т.е. между другими узлами. Распределенная виртуальная коммутация обеспечивает централизованный мониторинг, управление конфигурацией на всех узлах вычислительного кластера. Распределённая виртуальная маршрутизация позволяет размещать виртуальные маршрутизаторы на вычислительных узлах и перенаправлять трафик виртуальных машин непосредственно с узлов размещения. В сценарии используется IP-адрес напрямую, назначенный сетевым интерфейсом. Если используется S, трафик перенаправляется через узлы управления. Как известно, технология внутри OpenStack, как и в киберинфраструктуре, использует технологии VxLAN для виртуальных сетей. Данная технология позволяет создать логические сети L2 в сетях L3 путем инкапсуляции поверх UDP-пакетов. Также есть интеграция со службами DNS и DHCP. Можно использовать RDMA поверх InfiniBand для кластера хранения, для организации внутренней сети хранилища. Внутренняя сеть хранилища как раз используется для организации хранилища. Ее можно построить на базе RDMA.

Также как в OpenStack в киберинфраструктуре возможно использовать мультиарендная архитектуру, которая используется при построении частных и публичных облаков.

В киберинфраструктуре используется административная иерархия доменов и проектов. Проекты еще называют тенантами с контролем доступа на основе ролей для управления виртуальными объектами вычислительного кластера, такими, как виртуальные машины, тома, виртуальные сети. Домен представляет собой изолированный контейнер проектов и пользователей с назначенными ролями. Каждый проект и пользователь может принадлежать только одному домену. Проект представляет собой изолированный контейнер виртуальных объектов с назначенными пользователями и заданными определенными ограничениями для виртуальных ресурсов, таких как виртуальные центральные процессоры, ОЗУ, хранилища и плавающие IP-адреса.

В соответствии с этими уровнями в продукте предусмотрено три роли пользователей: системный администратор, администратор домена и участник проекта.

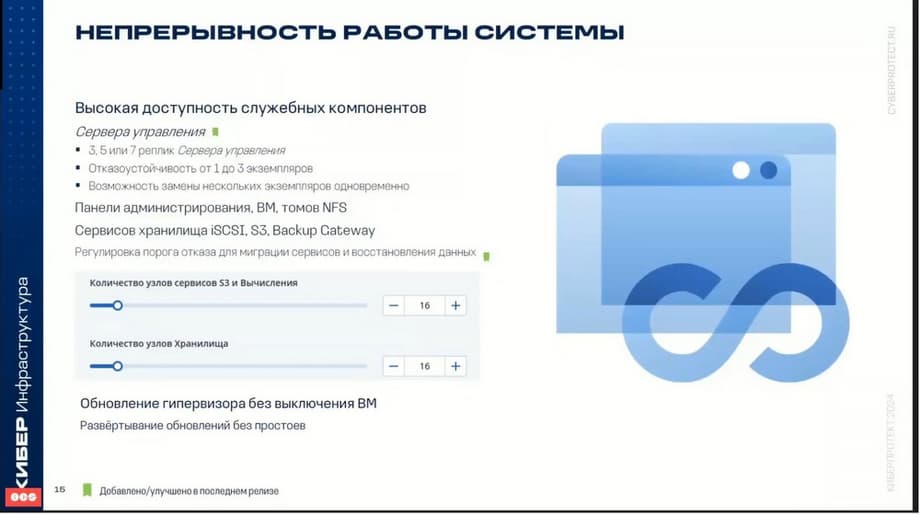

Непрерывность работы. Высокая доступность обеспечивает работу служб киберинфраструктуры даже в случае отказа узла.

В случае отказа какого-то узла, службы, которые работали на этом узле, перемещаются на исправные узлы в соответствии с алгоритмом консенсуса RAFT, который используется как раз отказоустойчивости в системе в случае сбоя. Какими методами достигается высокая доступность? Во-первых, это избыточность метаданных. Для надежного функционирования необходимо настроить несколько серверов метаданных. Для того, чтобы в случае сбоя одного, другие узлы подхватили эту работу. Избыточность самих данных – это второй способ, который тоже используется для обеспечения непрерывности и защиты данных.

Киберинфраструктура обеспечивает высокую доступность всех сервисов. Имеется в виду панель администратора. Сервер управления обычно кластеризуется, и обычно в системе существует несколько серверов управления.

Виртуальные машины. Если виртуальная машина выйдет из строя, то киберинфраструктура, сама система виртуализации, перемещает эту машину на другие свободные узлы. Сервисы iSCSI, I3, S3, Backup Gateway, NFS, все эти сервисы защищены от сбоя.

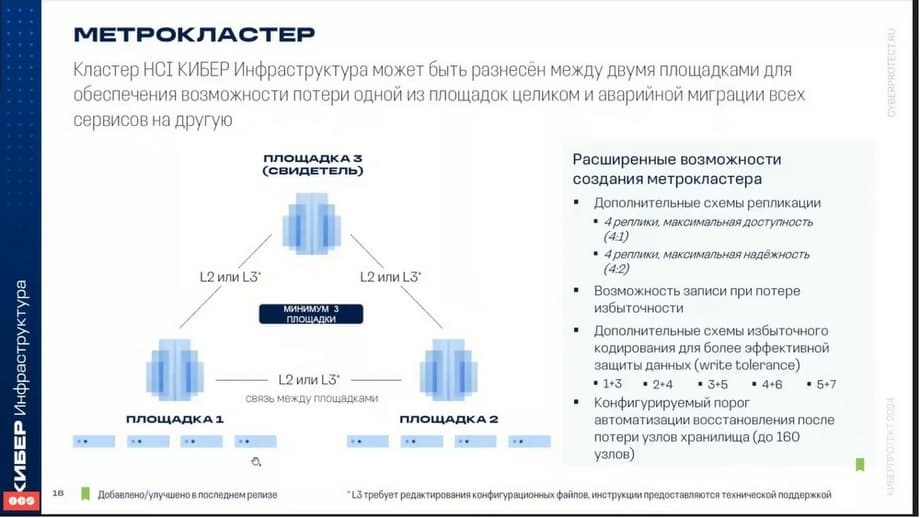

Метрокластер. В одной из последних версий появилась возможность построить метрокластер, т.е. разнести узлы киберинфраструктуры между разными площадками для исключения вероятности потери площадки целиком.

Централизованное управление.

Управление инфраструктурой осуществляется различными способами. Для этого есть основной инструмент - веб-интерфейс, командная строка, так называемый интерфейс vinfra CLI и также OpenStack API, программный интерфейс OpenStack. Web-консоль - это основной визуальный интерфейс управления вычислительным кластером и кластером хранилища. Через Web-консоль доступны управления серверами, сетями, пользователями, самообслуживанием, ролями, безопасностью и т.д.

Интерфейс командной строки Vinfra служит для управления кластером хранилища и вычислительным кластером. Поддерживает, единый синтаксис и различные форматы команд.

Ну, и наконец OpenStack - программа интерфейса управления, позволяет реализовать определенные возможности для управления.

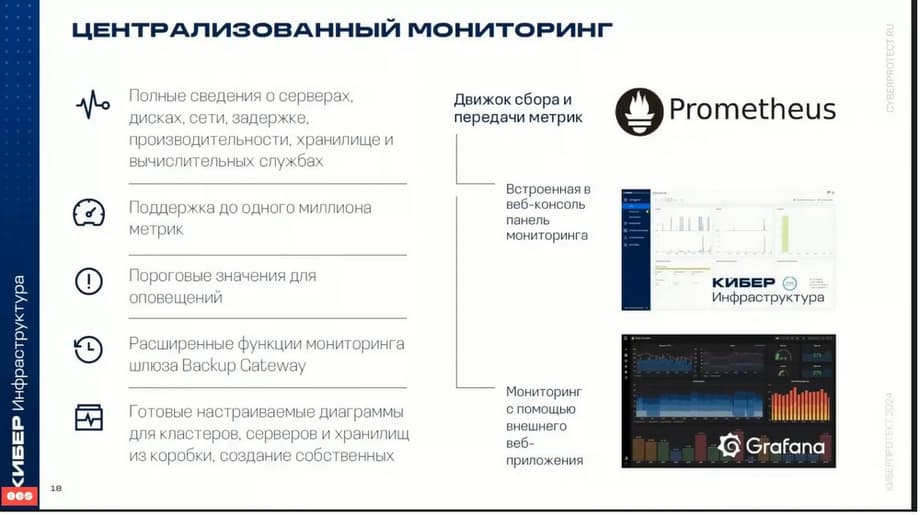

Система мониторинга служит для отслеживания работоспособности инфраструктуры и ее компонентов. Включает автоматизированный сбор метрик со всех компонентов системы: серверов, дисков, сетей, хранилищ, вычислительных служб и т.д. Киберинфраструктура позволяет просматривать все сведения о серверах, дисках, сетях, задержках, производительности и управлять порогами значений для оповещения.

Также используют киберинфраструктуру системы мониторинга Prometheus. И также с помощью внешнего веб-приложения Grafana можно рассматривать подробные диаграммы для кластеров, серверов, хранилищ. И имеется возможность создания собственных панелей мониторинга и диаграмм.

Рекомендованные аппаратные требования. Здесь представлены минимальные требования и рекомендованные.

Надо сказать, что для того, чтобы выбрать, какие сервера использовать, необходимо провести некий sizing. Для того, чтобы оценить sizing, нужно понимать, будет ли на этом кластере только хранилище или там будет одновременно и хранилище, и вычислительная инфраструктура, т.е. подниматься виртуализация. Для того, чтобы определить, например, какое количество взять CPU и памяти, необходимо тоже понимать, будет ли это опять штука хранилища или виртуализация. Если это будет виртуализация, то нужно оценить какой-то предельный объем виртуальных процессоров, который нужен для виртуализации, и предельный объем памяти. Для хранилища необходимо понимать, какие типы хранения данных будут использовать, т.е. какие сервисы будут работать. Каждый сервис требует какие-то свои параметры.

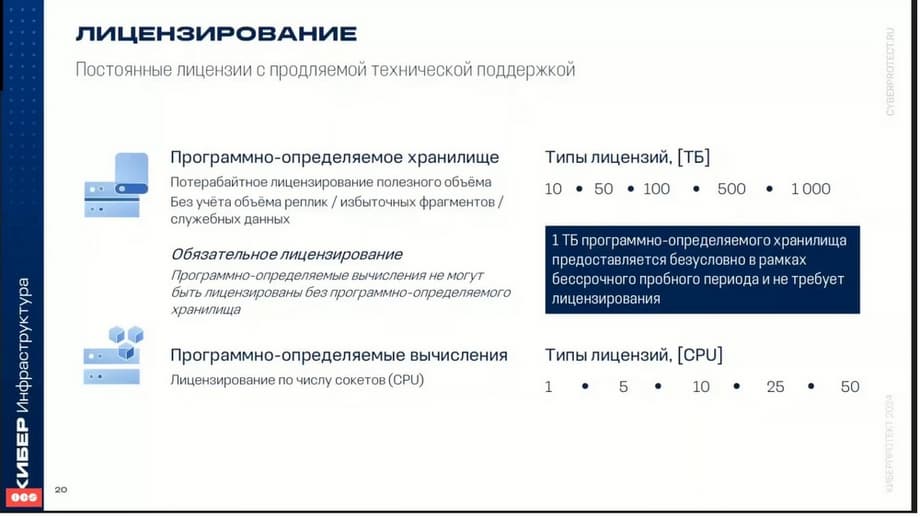

Лицензирование. Хранилище лицензируется по терабайтам, и лицензируется именно полезное пространство. Что касается виртуализации, то лицензируются по количеству сокетов сервера. Следует сказать, что для того, чтобы развернуть в тестовом окружении, входит бесплатная лицензия на 1 ТБ, она входит в состав пробной версии.

Иллюстрации предоставлены компаний «Кибепротект».

Сейчас на главной